Web Scraping có thể hiểu khái quát là việc lấy thông tin hoặc dữ liệu. Tuy nhiên không phải ai cũng thực sự hiểu về Web Scraping cũng như những công dụng và mặt tiêu cực mà nó mang lại. Chính vì vậy để giải quyết vấn đề nan giải này thì hãy cùng Tmarketing xem qua bài viết sau để hiểu rõ hơn cũng như giải đáp những thắc mắc của các bạn.

Web Scraping là gì? Những lĩnh vực thường được áp dụng

Web Scraping là gì?

Web scraping là một quá trình tự động thu thập thông tin từ website. Thông tin này được thu thập và sau đó xuất thành định dạng hữu ích hơn cho người dùng (có thể là bảng tính hoặc API).

Quá trình này có thể được thực hiện thủ công bằng cách sử dụng phần mềm, tuy nhiên phần lớn khi nhắc đến web scraping tương đương với quá trình thu thập dữ liệu tự động được triển khai bằng bot hoặc các web crawler.

Có 2 kiểu scraping thông dụng bao gồm: Site scraping và Database scraping

Những lĩnh vực thường được áp dụng Web Scraping

Theo thống kê của Linkedin tại Mỹ, Web Scraping được sử dụng trong 54 lĩnh vực khác nhau. Trong đó, 10 lĩnh vực sử dụng công cụ này phổ biến nhất phải kể đến là:

- Phần mềm máy tính (22%)

- Công nghệ thông tin và dịch vụ (21%)

- Dịch vụ tài chính (12%)

- Internet (11%)

- Tiếp thị và quảng cáo (5%)

- Bảo mật máy tính & mạng (3%)

- Bảo hiểm (2%)

- Ngân hàng (2%)

- Tư vấn quản lý (2%)

- Truyền thông trực tuyến (2%)

Công dụng của Web Scraping

Một số công dụng nổi bật của Web Scraping có thể kể đến đó là:

- Trích xuất dữ liệu từ một công cụ định vị cửa hàng để tạo danh sách các địa điểm kinh doanh

- Trích xuất dữ liệu sản phẩm từ các trang web như Amazon hoặc eBay để phân tích đối thủ cạnh tranh

- Trích xuất dữ liệu từ YellowPages để tạo khách hàng tiềm năng

- Trích xuất dữ liệu từ một công cụ định vị cửa hàng để tạo danh sách các địa điểm kinh doanh

- Trích xuất chi tiết sản phẩm để so sánh khi mua sắm

- Trích xuất dữ liệu trang web trước khi di chuyển trang web

- Trích xuất dữ liệu tài chính để nghiên cứu thị trường

Cách thức hoạt động của Web Scraping

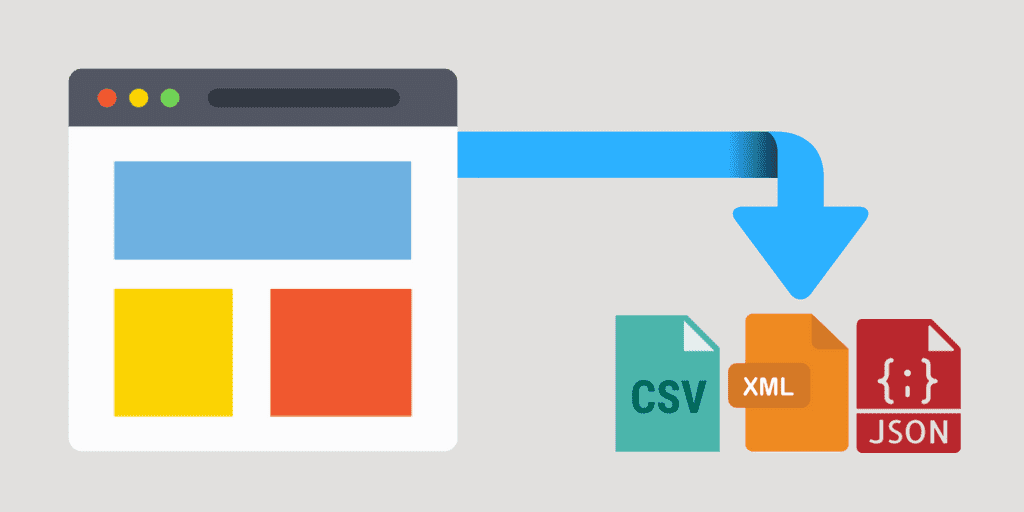

Bước 1: Web scraper sẽ được cung cấp một hoặc nhiều URL để tải trang trước khi sao chép dữ liệu. Tiếp theo, scraper sẽ load toàn bộ code HTML cho trang đang đề cập. Các công cụ scraper nâng cao hơn sẽ hiển thị toàn bộ trang web, bao gồm cả các phần tử CSS và Javascript.

Bước 2: Sau đó, scraper sẽ trích xuất tất cả dữ liệu trên trang hoặc dữ liệu cụ thể được người dùng chọn trước khi chạy project. Lý tưởng nhất, người dùng sẽ trải qua quá trình chọn dữ liệu cụ thể mà họ muốn từ trang.

Bước 3: Cuối cùng, web scraper sẽ xuất ra tất cả dữ liệu đã thu thập được thành định dạng hữu ích hơn cho người dùng.

Hầu hết các web scraper sẽ xuất dữ liệu sang bảng tính CSV hoặc Excel, trong khi các scraper nâng cao hơn sẽ hỗ trợ các định dạng khác như JSON, có thể được sử dụng cho API.

Có phải mọi Web Scraping đều xấu?

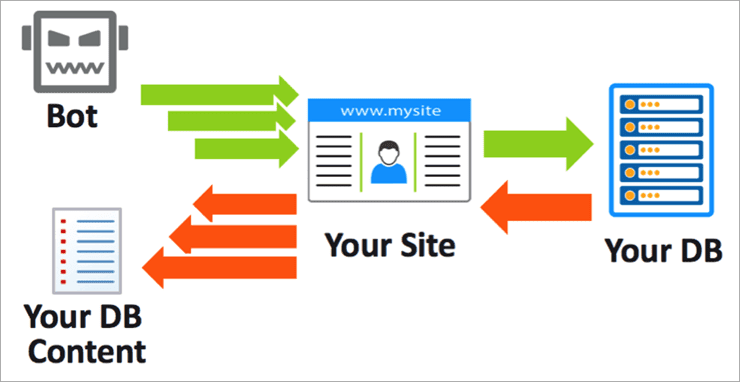

Nhiều người nghĩ rằng, việc sử dụng Web Scraping để quét, đánh cắp dữ liệu là hành động xấu.

Trong nhiều trường hợp, chủ dữ liệu muốn truyền tải dữ liệu đến càng nhiều người càng tốt. Ví dụ website của nhiều chính phủ cung cấp dữ liệu cho các website công cộng. Các con bot sẽ lấy dữ liệu về từ API hoặc Scraping. Tiến hành phân loại nội dung rồi điều hướng lưu lượng đến website.

Web Scraping hợp pháp

- Các máy tìm kiếm sử dụng bots để lấy dữ liệu phục vụ phân tích và xếp hạng nội dung website.

- Các bot hợp pháp được xác định với tổ chức mà chúng scrape, tuân theo file robots.txt.

Web Scraping độc hại

- Mục đích đánh cắp tài sản sở hữu trí tuệ, danh sách đơn giá và khách hàng

- Tạo lợi thế giá cả nhờ thu thập và phân tích giá từ đối thủ

Cách ngăn chặn Web Scraping độc hại

Site scraping là một công cụ mạnh mẽ. Với mục đích đúng đắn, nó giúp tự động hóa việc thu thập và phát tán thông tin. Với mục đích sai, nó có thể dẫn tới đánh cắp tài sản trí tuệ hoặc gây ra cạnh tranh không lành mạnh.

Chủ website có thể thực hiện các phương pháp sau để phân loại và giảm thiểu các con bot, bao gồm cả việc phát hiện Scraping Bot:

Sử dụng công cụ phân tích:

Người dùng sử dụng các công cụ phân tích, đánh giá và kiểm tra cấu trúc web request cùng kết hợp dữ liệu của các con bot trả về. Chủ website sẽ xác định được kịp thời đâu là con bot cần ngăn chặn.

Sử dụng robots.txt:

Chủ website có thể sử dụng robots.txt để bảo vệ website trước scraping bot, nhưng cách này không có hiệu quả lâu dài. Đây là tệp tin hướng dẫn các con bot thực hiện theo luật định sẵn.

Đôi khi bạn lúc bạn phân tích lại cấu trúc website sẽ thấy một vài con bot độc hại tồn tại trong thư mục Robots.txt mà chủ website không muốn Google index và khai thác chúng.

Challenge-Based:

Sử dụng các công nghệ web để đánh giá hành vi của client như nó có hỗ trợ cookie và JavaScript hay không? Chủ website cũng có thể sử dụng CAPTCHA để chặn các một vài cuộc tấn công.

Sử dụng robots.tx:

Các con bot đều tự liên kết với các chương trình client gốc. Vậy nên, bạn cần phát hiện ra đâu là con bot có điểm khác biệt với client gốc hoặc phát hiện các điểm bất thường nhằm ngăn chặn, giảm thiểu.

Sau đây là những nội dung Web Scraping cũng như những lợi ích và tiêu cực mà nó mang lại, hy vọng qua bài viết của Tmarketing sẽ có ích và giúp bạn giải đáp thắc mắc cũng như những những vấn đề của bản thân đang mắc phải. Nếu có bất kì thắc mắc nào bạn có thể liên hệ với Tmarketing đơn vị chuyên thiết kế website xây dựng , thiết kế website bán hàng online và cung cấp các giải pháp về website – hosting – VPS các giải pháp về Digital Marketing để giải đáp các thắc mắc nhé !